数据建模能力、数据开发技术固然是非常可贵,友盟+也发现,人人都能上手的、统计性、描述性的数据分析,同样能发挥出巨大的洞察作用和价值。

作者:友盟+资深数据分析师 相峥、阿里巴巴数据及产品部专家 徐珊

疫(zhái)情(jiā)期间,数据分析领域涌现出很多民间高手,数据玩家各显神通,或通过仿真程序调参,模拟病毒传播,强调不要出门对控制传播的重要贡献;或用自然语言处理工具+词云,直观展示每日新闻热词的演进变化,或现场教学如何爬取网站上的实时病例数据,用作进一步分析。

这些数据建模能力、数据开发技术固然是非常可贵,但是我们也发现,人人都能上手的、统计性、描述性的数据分析,同样能发挥出巨大的洞察作用和价值。

数据分析的七个方法

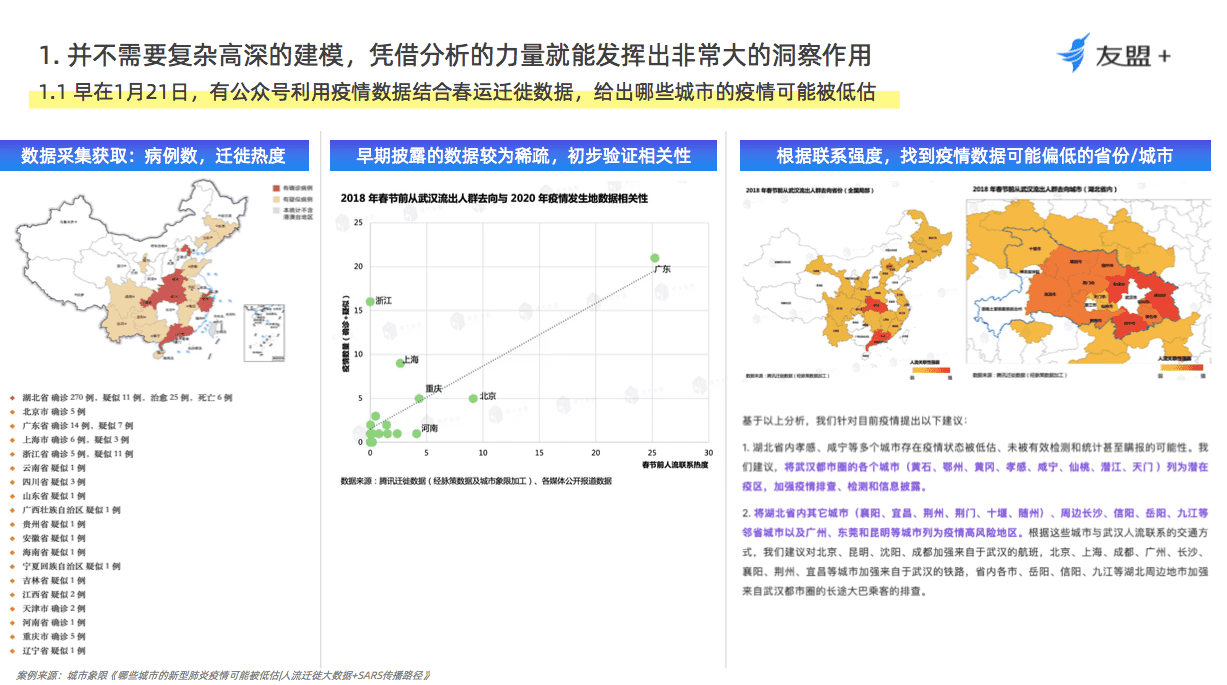

早在1月21号,大众对疫情的关注度刚开始爬升的时候,有公众号把各省市病例数据和往年春运迁徙数据做了一个“略显粗糙”的相关性分析,根据初步验证的正相关关系指出,湖北省内一些城市和武汉来往密切,疫情状态可能被低估,湖北省外的重点城市要加强机场或铁路方面的预警。这些分析就充分运用到了趋势监测、横向对比、维度拆解等来判断的。

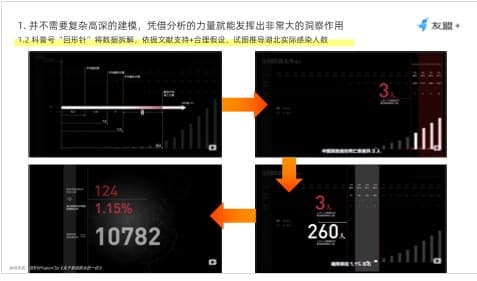

如在科普号“回形针”的视频中,这样一个数据推导小环节令人印象深刻。

⁃首先,作者认为,湖北省内外的疫情发展状况差异很大,湖北省内的确诊诊断工作压力较大,很可能在数字上有滞后,因此要将湖北和非湖北数据“拆分来看”。

⁃下一步,他认为用总病死人数除以总确诊人数得到的病死率,是不准确的,快速增加的确诊病例数(分母)会稀释这个百分比,于是选择采取尽可能接近“同期群”的方式来处理。

⁃进而,他依据当时文献,得知报告确诊到报告死亡的平均时间是8天,那么最近3天的新增死亡病例大概率来自8天前确诊的那些新增病例,在这样一个“同期群”当中,得到湖北省外病死率在1.1%左右的,如果暂且认为湖北省内病死率也在相近的水平,那么反除可得到上万人的湖北省内感染人数。

⁃根据现在的信息,湖北省内的病死率会比其他地区高一些,所以这个计算结果可能是大几千这个水平,这与后续疾控中心披露的数据非常接近,而作者精巧的分析得益于对数据进行合理的“维度拆分”和“同期群”思路的应用。

还有我们每天会关注的疫情数据报表。以丁香园为例,丁香园出品的数据报表,用公众都能理解的朴素数据分析,细致解读国家和各地卫健委公布的疫情数字,帮助大家提高对疫情的正确认知。它善于:

-不靠肉眼看趋势,用环比量化增长率

-针对数据波动(如新增确诊一日暴增一万,病死率降低后又逐步走高),有理有据给予说明

-对比SARS、MERS、H7N9等重大疫情的相关数据,认识本次疫情特征

-将关键指标按省份/城市拆分,结论更清晰明了

-除了宏观指标,就特殊群体感染情况(如老年人、医务人员)做详细分析

-确保指标计算与分析解读的专业性,及时指正市面上流传的错误图表

不难发现,我们每天看到的优秀数据解读背后蕴含着数据分析的七个方法:

-

趋势监测:指标定义正确,历史口径一致

-

横向对比:参照对象可比,广泛收集数据

-

维度拆解:维度拆分合理,结论指导行动

-

过程拆解:业务逻辑清晰,指标表征转化

-

因素拆解:铺展相关因素,数据掌握全貌

-

分群洞察:分群不重不漏,圈人深度描摹

-

个案细查:采集最细颗粒,多源数据关联

三驾马车 产出高价值数据分析

现在已经是2月末,大部分人已陆续复工,那么回到我们自己的业务上,如何更好的做好数据监测呢?

数据分析光有思路还远远不够,对具体业务的理解、数据采集的质量、分析工具的灵活是让数据分析高效率地产出价值的三驾马车。有了业务理解,才能提出合适的问题、规划数据需求,在采集上就尽量确保全面、口径一致、颗粒度满足拆分需求,到了分析环节的时候,有灵活的工具来实现各种折腾数据的想法,再有业务理解去加持数据的解读,这样才是真正能发挥价值的数据分析工作。

首先,业务理解和数据采集是数据分析、数据化运营非常重要的前提条件,指标体系就相当于是二者之间的重要桥梁,也是很重要的一个落地产物和载体。如果是数据相关的岗位,强烈建议大家去牵头了解各个业务方、甚至是管理层,他们的业务目标是什么,他们想要看数据是要回答什么样的问题,从而避免成为一个被动的、没有灵魂的SQL Boy。

如果是产品、运营等等业务岗,对这个问题的再度思考也不为过,虽然“核心指标 = 业务阶段 * 行业特点 * 企业战略”,但是前两者属于一般性的规律,同一个行业、同一个发展阶段的企业,也会因为商业模式、优势、发展侧重的不同,量身定制核心指标,因此,“企业战略”一定程度上凌驾于前两个因素之上,不仅是一个监测作用,更是一个指引,代表了战略决策、业务目标的方向。

接下来,明确了核心指标之后,日常需要用到的指标应做好分级分类,不仅有利于数据的管理和使用,也能全面规范地对埋点工作提出需求,确保采集的准确和连贯。大体上遵从战略管理层面的核心指标、业务线层面的子指标、业务执行层面的过程指标的原则,具体拆解没有严格的一定之规,几个常见的方法有:

● 类似杜邦分解的树状结构,指标之间尽量保持明确的公式关系

● 用户生命周期*分析主体,借助分析视角的不同,沉淀相应的维度搭配

● 再或者,直接依照业务线/团队职责划分,更加方便需求的收集

一个工具 助你数据分析降本提效

工欲善其事,必先利其器,为了帮助大家在数据分析这件事情上能够降本提效,友盟+全新发布了U-DOP数据开放平台。

其一,把SDK为大家规范采集的多端数据,一键返还到客户自有云空间,保障大家能够在最细颗粒度、最自由地进行拆分和数据关联。同时我们也根据多年服务开发者的经验,预置了一些常用指标,提前计算好,不用事事都要从最底层开始处理和计算,避免一些麻烦和错误。

(个体明细、预置指标数据,一键返还至客户自有云空间)

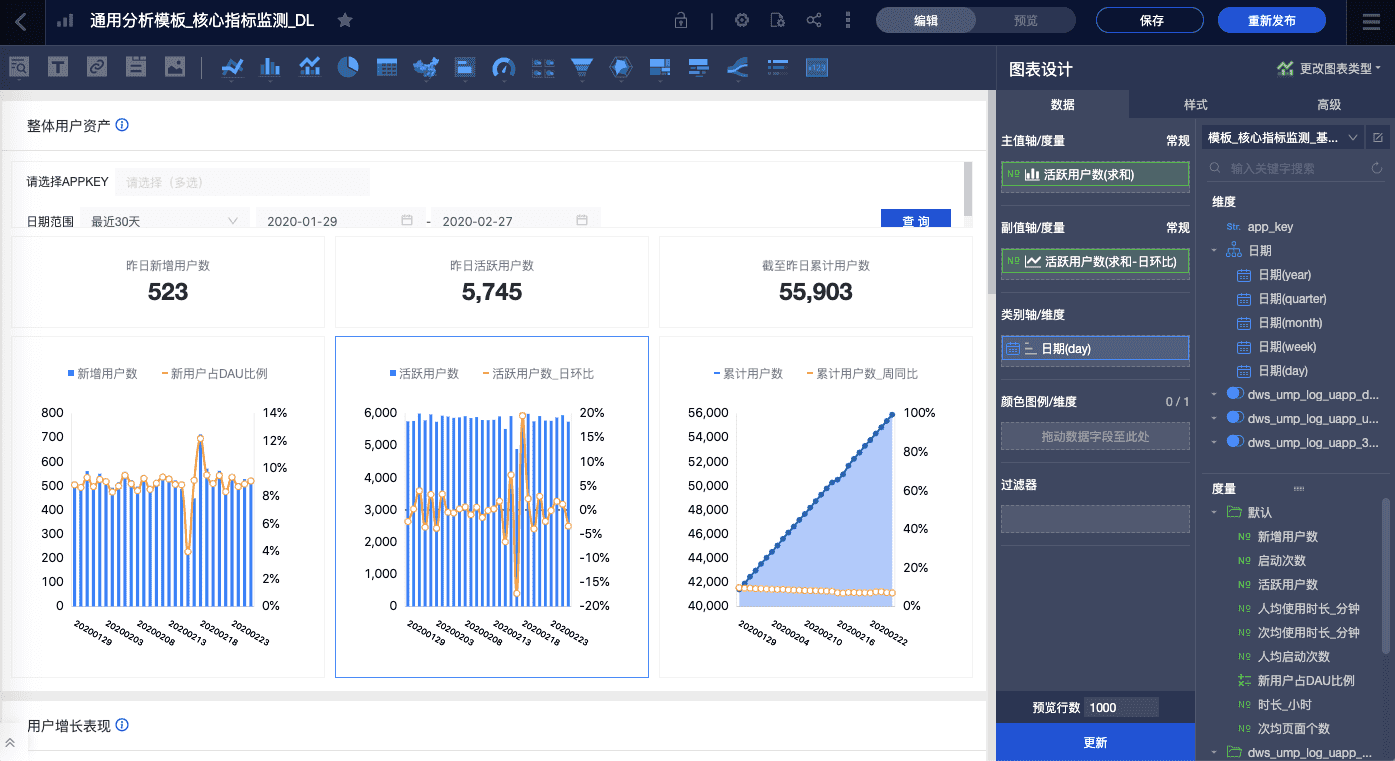

其二,开发者可能习惯于U-App这样的移动统计分析套件,突然间得到了最大的灵活性,可能反而不知道怎么上手了,我们也希望尽量能帮大家扶上马 送一程,在DOP中不断上新主题分析模板,把我们在各个场景各个行业的分析思路固化下来。一方面辅助大家理解我们返还的数据是什么,可以怎么使用,另一方面给到大家示意,可以照猫画虎,熟悉上手我们的分析平台如何使用。

(预置模板,及其背后的仪表板“托拉拽”编辑界面)

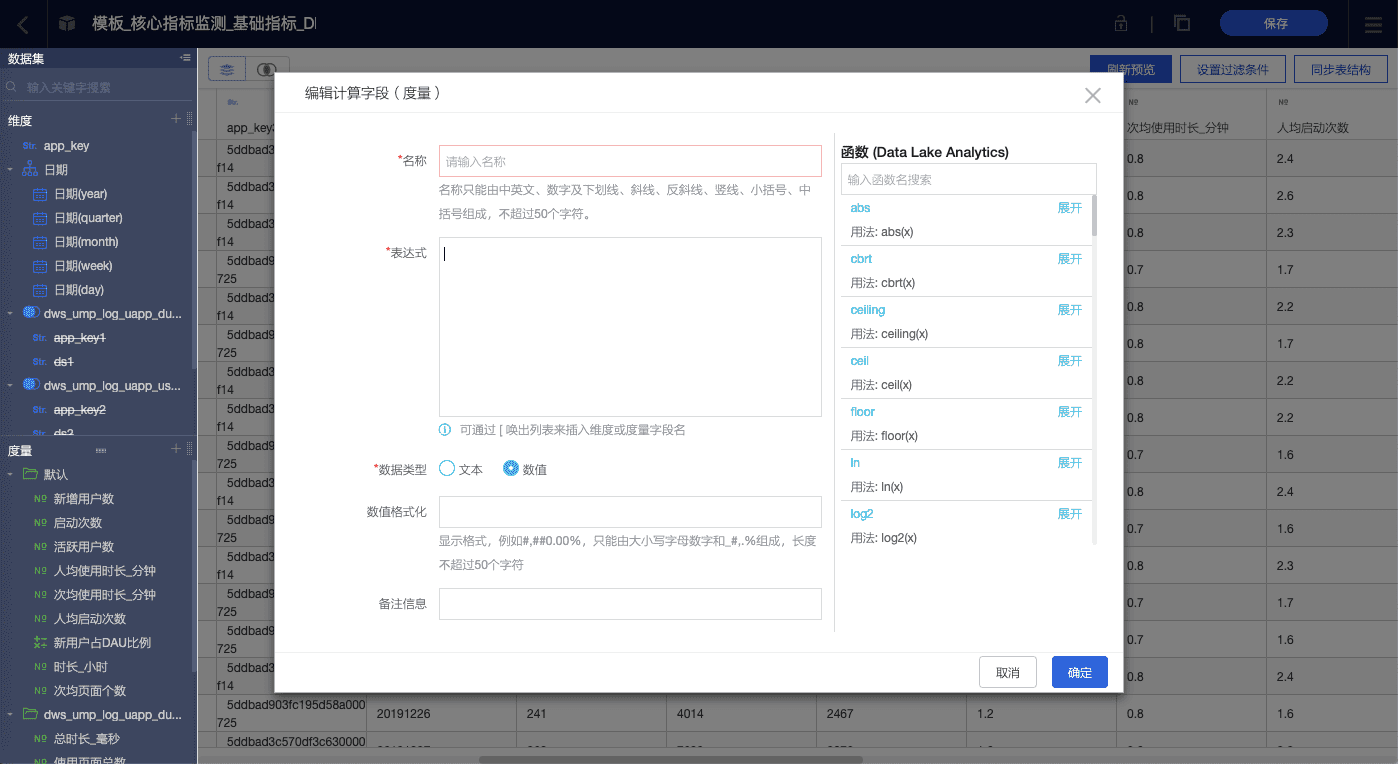

(数据集可编辑界面,调整数据格式、新增计算字段、关联其他数据表等等)

其三,大家各自的业务一定是有自身的特点的,不可能靠模板走天下,大家的数据也远远不仅是App的行为数据,一定也是多个数据源。在这样的背景下, DOP深度整合了阿里云的相关产品,在数据存储、计算、BI工具方面无缝衔接,给到大家数据融合、自助分析的能力,更加顺畅一体化的完成数据灵活分析。

作为DOP的重要组成部分,QuickBI承载着自助分析场景下的数据加工、分析与可视化等工作。到底怎样完成一次数据分析呢?简单归结起来就是“四步走”,如图所示:

首先,数据获取。除了友盟+将采集的行为数据自动投递至云数据库,Quick BI作为阿里云上的官方BI产品,能够无缝集成云上数据:支持云数据库、关系型数据库、Hadoop、本地文件等,和阿里云数据库无缝对接。如前面介绍过的,友盟+提供的数据原料可细至个体、会话颗粒度,因此满足不同层面的数据拆分或关联,例如通过用户id,将行为数据和交易、CRM数据打通,或通过渠道名称,将渠道拉新的留存率和该渠道用户的ARPU数据拉通,得出LTV。

其次,通过创建数据集来数据处理。Quick BI即保留了传统的SQL方式完成数据加工和处理,也支持通过创建数据集用交互式方式完成数据的加工,比如表关联、重命名、新建字段、过滤等。

最重要的,有了数据,开始拖拽分析。Quick BI具备丰富的数据可视化能力:将数据字段拖拽至维度、度量中,可视化图表组件瞬间生成,近40种可视化图表任你挑选,满足各种报表场景,同时支持制作在线电子表格和快速搭建数据门户,轻松完成数据分析。

最后,分析报表发布分享。一端配置,多端支持,数据需求方随时随地查看报表内容。报表制作者还可以配置阅览者的数据查看或编辑权限,不必担心看版被误操作或数据权限无法管理的问题。

【扩展学习】阿里做数据分析的三大意义与四大痛点

数据分析的三大意义:

一,数据丰富知识体系。通过数据去发现数据背后的知识,提炼出推动业务发展的决策。

二,数据服务生产。我们有数据,其实是休眠的,需要利用它服务沉默的产品和客户。

三,就是数据实现商业价值。通过数据分析和挖掘做到控制风险、提升效率,增加收入,发现新的商业模式。

在过去阿里数据驱动业务的过程中,遇到的四大痛点:

一,业务发展快。需求多但人少,而且经常碰到需求特别多的时候但是时间比较紧。

二,数据响应流程长且不统一。需求需要不同角色的多轮沟通、数据处理过程无法标准化且技术人员对数据沉淀过少。

三,数据本地化严重。常规的数据分析我们习惯用本地的Excel,但是这样会带来一个问题,数据都存在Excel如果人走了怎么办,会导致数据业务从零开始;而且本地化查询,数据安全不可控。

四,专业人才的紧缺。很多的企业可能几百个人,但是分析师只有少数几个,基本上都是用来服务CEO或者是CTO的数据分析需求。 很多数据同学根本无法深扎到数据分析更深的领域。

-

友小盟数据官服务号 随时掌握,最新友盟+产品动态

-

友盟全域数据 前沿的行业数据新风向

-

友小盟数据官 随时随地查看您的数据报告